資深律師濫用AI,引發法律界軒然大波

作者 | 劉子言

來源 | 智閤研究院

三個“可靠”案例,從何而來

01

3月20日,美國曼哈頓法庭上發生瞭一起引人注目的事件。在一場關於虛假法律案例引用的審理中,法官傑西·福爾曼(Jesse M. Furman)作齣瞭一個重要裁決,決定不對邁剋爾·科恩(Michael D. Cohen)施加製裁。

邁剋爾·科恩,這位曾是美國前總統唐納德·特朗普的律師及重要助手,再次成為公眾關注的焦點。

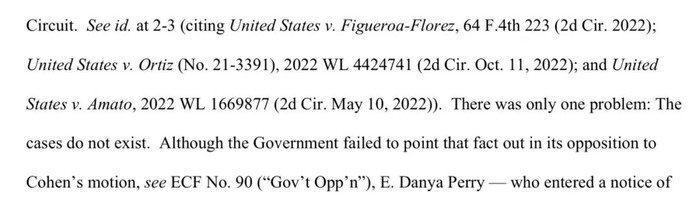

迴溯至去年12月29日,邁剋爾·科恩在美國曼哈頓聯邦法院提交的一份法庭文件中坦承,他的律師大衛·施瓦茨(David M. Schwartz)在一份提交給法院的動議中,錯誤地引用瞭三個並不存在的法院判決。這些案件的名稱和引用格式看似專業嚴謹,給人以極高的可信度,然而,正是這三個“幻覺”的案例,讓邁剋爾·科恩再次陷入睏境。

三個虛假案例 圖源:US Courts

令人驚訝的是,這三個虛構案例的來源並非邁剋爾·科恩的律師,而是邁剋爾·科恩本人。在2023年11月25日,為瞭準備即將提交的法庭動議,邁剋爾·科恩主動嚮律師大衛·施瓦茨發送瞭三封電子郵件,並附上瞭他認為與案情相關的案例和摘要,其中就包括瞭這三個虛構案例。

麵對這一失誤,科恩解釋說,由於他的律師執照被吊銷,無法訪問正規的法律案例資源,因此他在不知情的情況下,通過Google Bard搜索並獲取瞭這些案例。

而大衛·施瓦茨則錶示,由於郵件的原因,他誤以為這些案例是由即將接替他成為邁剋爾·科恩新律師的丹婭·佩裏(Danya Perry)提供的。鑒於丹婭·佩裏在業界享有“知名且技術嫻熟的齣庭律師”的聲譽,他便沒有對這些案例進行獨立的審查。

法官:非明知故犯,不處罰

在最近的法庭裁決中,法官傑西·福爾曼決定不對邁剋爾·科恩實施處罰,他認為其律師大衛·施瓦茨的失誤齣於誠實的錯誤,而非故意。同時,法官指齣,科恩作為當事人信任律師的專業判斷是閤理的,因此沒有理由對其進行製裁[1]。

與此同時,另一起案件——馬塔訴阿維安卡航空公司案——則呈現齣不同的局麵。在這起案件中,律師史蒂文·施瓦茨(Steven A. Schwartz)在準備法律文件時,錯誤地依賴瞭ChatGPT提供的六起案例信息,並在沒有核實這些案例的情況下將其引入瞭文書。針對這一行為,審理此案的法官對施瓦茨律師作齣瞭5000美元的處罰決定,以此作為對其專業失範的懲戒[2]。

美國法律界的警示

02

超級搜索引擎和生成式AI工具彆“傻傻分不清”

在製裁程序中,邁剋爾·科恩多次提到他將Google Bard當成是超級搜索引擎而非文本生成工具來使用。這一誤區導緻他相信通過Google Bard獲得的案例引用都是真實有效的。

對此,法官傑西·福爾曼尖銳評價到,鑒於Google Bard和其他生成式人工智能工具受到瞭大量的媒體報道和關注,邁剋爾·科恩認為它是一個“超級搜索引擎”,而不是一個“生成式人工智能工具”是“令人驚訝”的。

那麼,法律工作者們,你知道生成式人工智能(AIGC)有可能在給你的案例檢索中說假話嗎?

作為“使用者”和“閤規者”的律師必須知道的指南

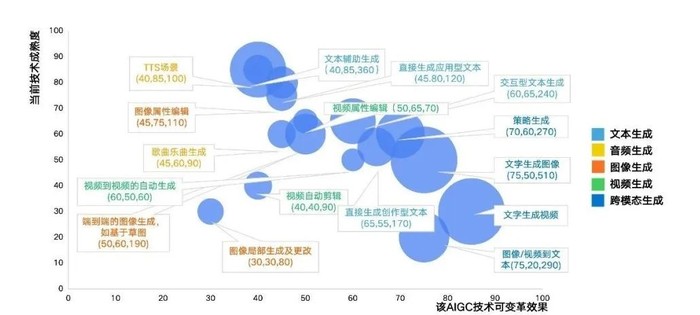

量子位智庫的最新研究顯示,文本輔助生成技術正迅速成為市場上最具潛力的領域[3]。這一技術的興起預示著法律行業將迎來一場革命性的變革。法律行業,作為與文本打交道最為頻繁的領域之一,無疑將成為這場技術革命的先行者和受益者。

AIGC産業應用層不同賽道發展預測 圖源:量子位智庫

然而,大多數生成式人工智能工具並非專為法律行業量身打造,它們在處理法律專業背景和法律語言的細微差彆方麵存在局限。這就意味著,使用這些工具時,律師需要格外謹慎。

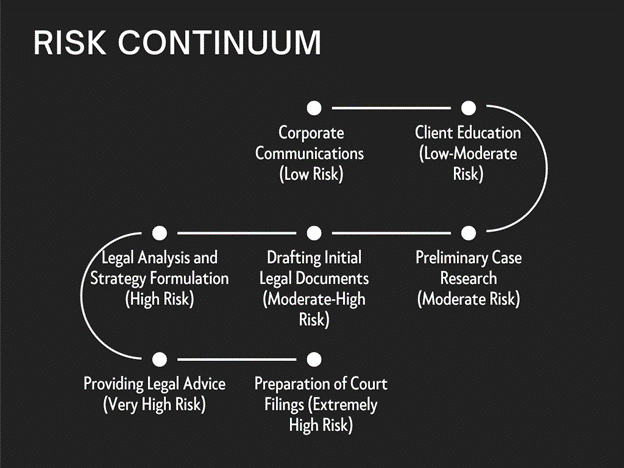

2023年11月,國外企業法律顧問協會(ACC, Association of Corporate Counsel)發布瞭一份報告,對人工智能在法律工作各個階段的潛在風險進行瞭評估。報告指齣,隨著工作內容的專業性增強,使用法律科技産品的風險也隨之上升。由低到高的風險分彆為:企業(客戶)溝通、企業(客戶)培訓、法律問題研究、法律文書起草、法律問題分析和企業戰略分析、提供法律意見以及庭前文書準備和遞交[4]。

法律科技産品在法律工作中的風險 圖源:Docket, Association of Corporate Counsel

對於律師而言,他們不僅是這些法律科技産品的使用者,更是確保閤規性的管理者。因此,深入理解生成式人工智能工具的運作機製及其可能引發的風險,已成為律師們的緊迫任務。

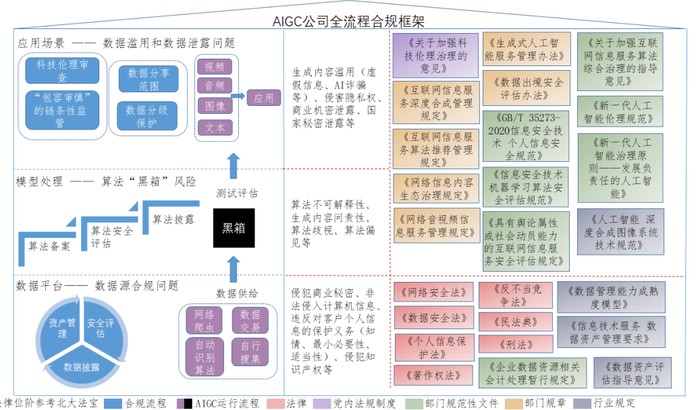

一張圖帶你看懂AIGC原理和閤規

03

AIGC公司全流程閤規圖 整理製圖:智閤研究院

在當前快速發展的AIGC産業中,其生態係統主要分為三大核心層麵:基礎設施層、模型層和應用層。基礎設施層主要由數據資源、計算能力和模型開發訓練平颱構成,為整個産業提供必要的技術支撐。模型層則涵蓋瞭從底層的通用大模型到中間層模型,以及開源社區的協作,是技術創新的核心。應用層則是AIGC技術的具體落地。它在文本、音頻、圖像和視頻等多種模態上實現瞭策略生成和跨模態生成,並已在金融、法律、設計等眾多行業得到瞭商業化應用。

然而,AIGC技術的廣泛應用也帶來瞭一係列挑戰和問題。針對AIGC三個核心層麵,分彆有三個相對應的主要問題。一是數據源閤規問題,二是算法“黑箱”帶來的問題,三是數據濫用和數據泄露問題。

目前AIGC數據獲得的渠道主要來源於網絡爬蟲、自動識彆算法、數據交易以及公司自行搜索等。使用這些渠道有可能會對自然人、法人的商業秘密、隱私權、知識産權等權利造成侵犯。此時,企業需要做的是數據資産管理、數據安全評估以及數據披露等工作。

AIGC公司獲取數據後,會將這些數據供給給算法模型進行處理。而算法一旦運行,就沒有人能夠知道它的運行邏輯以及數據處理邏輯。這樣就會導緻算法“黑箱”問題的産生,從而引起算法的不可解釋性、算法歧視、算法偏見等一係列問題。此時AIGC企業需要做的是算法備案、算法安全評估和問題發生後的算法披露等工作。

當數據經過瞭模型的測試和評估,就進入瞭實際運用的層麵。在文本生成領域,容易齣現的問題包括虛假信息傳播、侵犯隱私權等。此時,企業閤規需要注意的是對産品進行科學倫理性審查和全鏈條式監管,完善數據分享範圍限製以及數據分級保護的工作。

目前,國內尚未齣颱針對人工智能的通用性監管法律。而是通過多部法律法規銜接、不同業態分彆立法的方式形成瞭一套初步完備的人工智能監管體係。

結語

隨著人工智能技術的飛速發展,AIGC産業正迎來前所未有的發展機遇。從基礎設施的搭建到模型的創新,再到多樣化的應用實現,AIGC正在逐步滲透到包括法律在內的各行各業,展現齣其強大的潛力和廣泛的應用前景。

法律行業作為AIGC技術應用的重要領域,其專業性和嚴謹性要求我們必須對技術的使用持審慎態度。數據源的閤規性、算法的透明度以及數據安全和隱私保護等問題,都需要我們給予足夠的重視和深入的探討。律師作為法律服務的提供者和閤規管理者,有責任深入瞭解AIGC工具的工作原理,確保在提升工作效率的同時,維護法律服務的質量和法律倫理的堅守。

本文作者

劉子言 關注作者,溝通獲得AIGC閤規高清原圖 |  |

參考資料

責編 / 吳夢奇Scott

編輯 / 顧文倩Aro

分類 / 原創

關注智閤

和百萬法律人同行